Les outils BI (Business Intelligence)

Introduction à la Business Intelligence

1) Qu’est-ce que la Business Intelligence ?

La Business Intelligence désigne les outils, les infrastructures et les pratiques offrant des accès à l’information tout en permettant leur analyse. Le but est d’améliorer et de déceler les informations les plus pertinentes. Ces analyses d’information ont donc pour objectif d’optimiser les décisions et la performance d’une entreprise.

Aujourd’hui, les entreprises utilisent différentes applications (CRM, ERP…) pour gérer leur activité. Ces applications permettent de stocker, d’analyser ou de modifier des données. Ainsi, chaque service peut utiliser de nombreuses applications sans pour autant qu’elles soient compatibles entre elles. La volumétrie de données collectées ou créées, l’absence d’uniformisation et les différentes applications utilisées rendent l’exploitation et l’analyse des données difficiles par les décisionnaires de l’entreprise.

Article écrit par Romain MIGNOT (AC), Ajaz GHULAM (CS), Amélien RETOURNE (M), Lei HE (SA) chez HeadMind Partners Digital

2) La chaîne d’informations décisionnelle et ses composantes

La chaîne d’informations décisionnelle comprend différentes phases :

- Alimentation, cette phase consiste à détecter, sélectionner, extraire, et charger l’ensemble des données brutes des différentes sources dans un datawarehouse, grâce aux outils ETL ou des traitements spécifiques des données.

- Modélisation, cette phase consiste à stocker et structurer les données dans un espace unifié, le datawarehouse, une fois que les données sont centralisées.

- Restitution, cette phase permet de mettre les données à la disposition des utilisateurs avec des outils Dataviz, de façon simple et selon leur profil et besoin métier.

- Analyse, cette phase permet une assistance de l’utilisateur afin qu’il puisse analyser les informations mises à disposition et prendre des décisions. Les données sont généralement modélisées par des tableaux de bord ou des rapports générés via des outils DataViz (Power Bi, Tableau, …).

I/ Les outils ETL

1) Qu’est-ce que les outils ETL

Les données traitées peuvent provenir de nombreuses sources différentes (ERP, réseaux sociaux, CRM, …). Les outils d’ETL (Extract, Transform, Load) permettent donc de tirer profit de l’accroissement constant de ces données collectées :

- L’extraction de données issues des différentes sources d’informations : Les ETL n’ont pas pour vocation de collecter de nouvelles données. L’extraction se fait via des connecteurs ou des APIs. Les données sont déjà présentes dans le SI de l’entreprise.

- La transformation de ces données : Les sources et formats de données multiples sont difficiles à exploiter. L’ETL transforme les données brutes pour les nettoyer, rendre conforme et standard, les documenter, corriger et dupliquer si besoin. Cette étape cruciale rend l’ensemble des données compatibles entre elles et au format cible.

- Le chargement des données transformées dans le DWH : Les données sont envoyées dans le datawarehouse une fois qu’elles sont transformées. Contrairement à un datalake qui est constitué de données non structurées, le datawarehouse est organisé et structuré sur la base d’un langage commun.

Les principaux avantages liés à l’utilisation d’un ETL :

- Améliorer l’exploitation des données de l’entreprise, même dans des environnements complexes, avec des sources de données multiples

- Avoir une vision exhaustive de l’ensemble des données de l’entreprise s’il est couplé à un datawarehouse

- Améliorer l’efficacité des équipes IT, car les processus ETL alimentent automatiquement et en temps réel le datawarehouse

- Accroître l’agilité de l’architecture SI car les ETL peuvent s’interfacer facilement à tout type de source de données

Cf. L’article « Introduction à l’informatique décisionnelle » pour plus de détail.

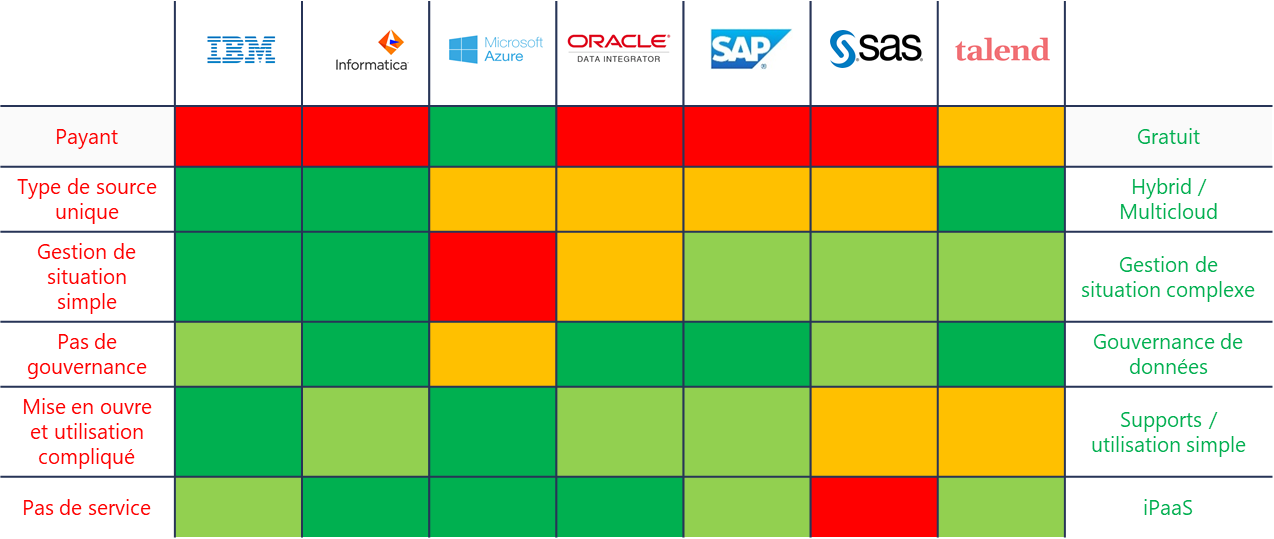

2) Choix de la solution ETL : Les leaders du marché

La plupart des leaders du marché sont des éditeurs historiques. Ces géants d’informatique maîtrisent la performance et les fonctions d’extraction, de transformation et de chargement. Tous ces géants offrent le management de données lors des traitements ETL. Ces outils traitent aussi bien en Cloud qu’on-premise.

Cependant, une bonne partie d’entre eux est spécialisée avec les produits de leur maison-mère et moins performante avec les autres technologies (ex. Microsoft, Oracle, SAP).

Les indicateurs de comparaison sont les suivants :

- La combinaison des sources hybride et multi-cloud

- Les coûts engendrés

- La complexité des situations traitées

- La facilité d’utilisation ou la qualité de support

- La gouvernance des données

- Les solutions SaaS/iPaas

En conclusion, chaque solution a ses avantages :

- Informatica est le leader du marché. Il est excellent pour son management de métadonnées, l’intégration des sources hybrides, et sa scalabilité. Il permet également d’intégrer plus de 100 sources de données / destinations, supporte plusieurs services et nombres utilisateurs. Mais la virtualisation des données et l’intégration par streaming ne sont pas ses points forts.

- Oracle est un outil robuste. Il est également fiable pour des charges de travail opérationnelles complexes. Par ailleurs, il est facile de trouver les experts Oracle. Cependant, il ne traite pas de cas d’usage complexe. De plus, la tarification est assez élevée.

- Talend focalise sur l’intégration indépendante des données hybride ou multi-cloud. En plus du management de données, il a une fonctionnalité RGPD. Par contre, trouver de la documentation ou des compétences Talend n’est pas simple.

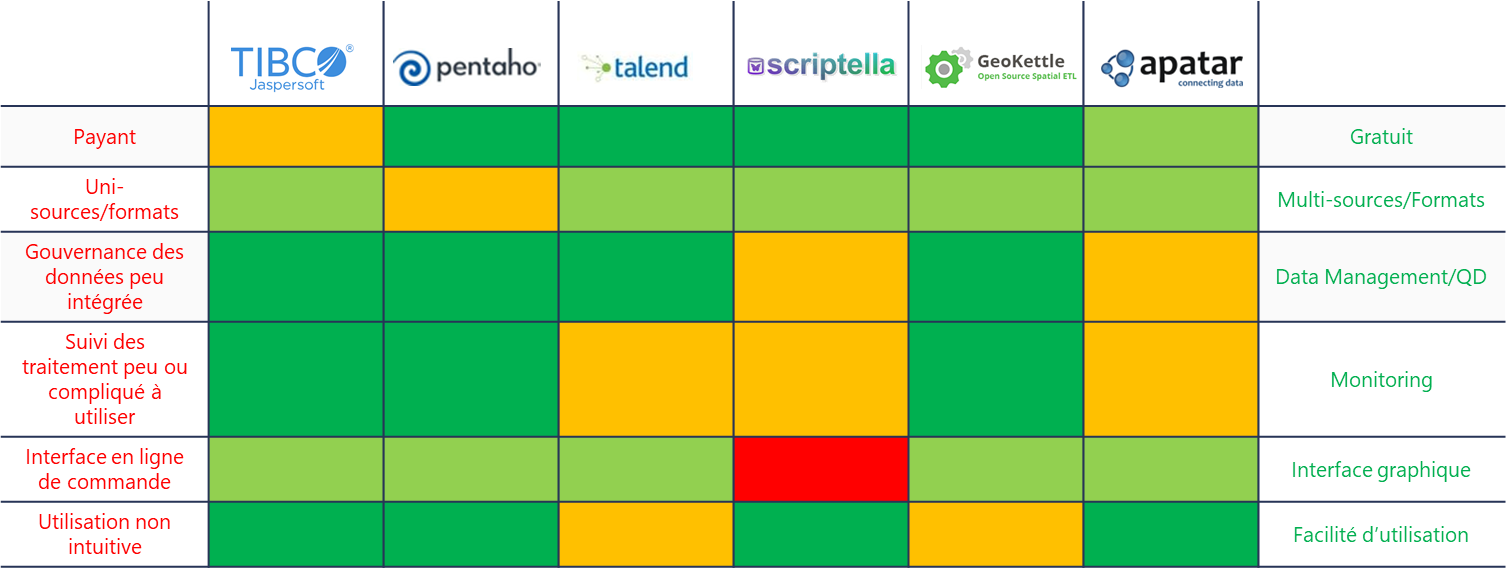

3) Les outils « open source »

Par rapport au prix affichés par les leaders du marché, il existe l’alternative de prendre un outil open source si la volumétrie des données et les fonctionnalités nécessaires restent standard.

En effet, les outils open source fournissent les fonctionnalités essentielles d’un ETL. Généralement, ils permettent de se connecter sur plusieurs types de sources et de technologies mais celles-ci doivent rester standard.

Attention, les outils open source ne sont pas forcément gratuits. Aujourd’hui, certains outils open source ont aussi une version commerciale / entreprise. Ex. Jaspersoft ETL, Pentaho, Talend Open Studio, Apatar. La version gratuite de ces outils n’a pas toutes les fonctionnalités proposées dans le package payant ou bien n’a pas de support / service.

Inexorablement, ces outils ne disposent pas de fonctionnalités aussi poussées et aussi larges que les leaders du marché mais chacun se concentre sur ses priorités.

Les indicateurs de comparaison sont :

- Les types de sources

- Les coûts engendrés

- Le management des données et la gestion de la qualité de données

- La facilité d’utilisation ou la qualité de support

- Le suivi des traitements

- L’interface graphique

En conclusion, chaque solution a ses particularités :

- Talend Open Studio : si le besoin est plutôt sur la transformation et la qualité de données.

- Scriptella : si le besoin est pour gérer la migration des données.

- Apatar : c’est un outil qui peut s’adapter aux utilisateurs métier, car il ne nécessite pas de connaissance de programmation.

- GeoKettle : cet outil permet aussi de traiter des données géospatiales.

II/ Les outils de stockage

1) Qu’est-ce que les outils de stockage ?

Les outils de stockage de la BI sont en grande partie des solutions applicatives de datawarehouse.

Le datawarehouse est une base de données au niveau détail dont la structure est représentée par un modèle de données normalisé, intégrant des données hétérogènes afin de les homogénéiser et de leur donner un sens unique compréhensible par tous les utilisateurs.

Cette intégration nécessite notamment :

- Une forte activité de normalisation et de rationalisation, orientée vers la qualité ;

- Une bonne gestion des référentiels, incluant une vérification constante de leur intégrité ;

- Une parfaite maîtrise de la sémantique et des règles de gestion des métadonnées manipulées et des moteurs ;

- Les données y sont non-volatiles, stables, non modifiables par les utilisateurs.

Définition de la modularité : chaque fonctionnalité (Entrepôt de données, Restitution, Moteurs…) est portée par un module distinct.

Autour du datawarehouse, on retrouve en général deux couches importantes :

- Le Staging : Une couche d’intégration (ou ODS) qui est positionnée en amont du datawarehouse pour supporter des traitements de contrôles techniques ou fonctionnels permettant les fonctions d’homogénéisation des différentes sources. Sur un plan d’architecture applicative, cette couche peut être intégrée au sein du datawarehouse ou être portée par un système dédié, en fonction des besoins.

- Le Datamart : Les datamarts (ou couche de restitution) donnent une vision métier des données, sont indépendants du datawarehouse mais s’alimentent uniquement du datawarehouse. Ils sont très souvent la source des outils de restitution.

Cf. L’article « Introduction à l’informatique décisionnelle » pour plus de détail.

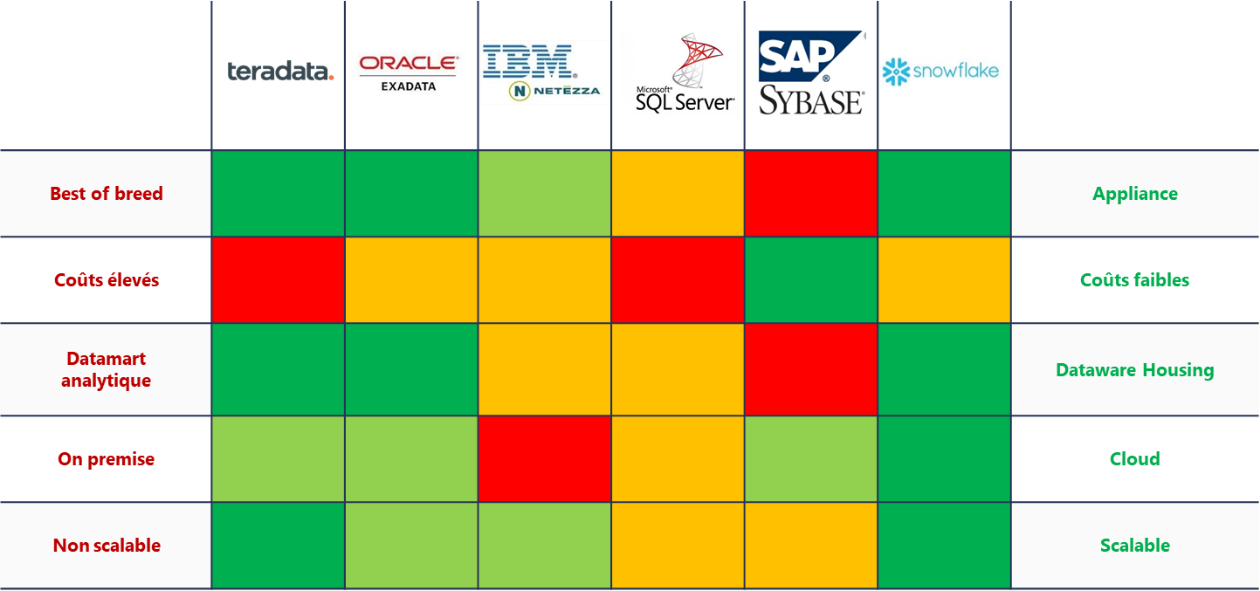

2) Choix de la solution de stockage : Les leaders du marché

Dans ce paragraphe, nous ne nous intéresserons qu’aux leaders du marché. Nous avons analysé les solutions proposées par les poids lourds du monde des softwares à savoir IBM, Oracle, Microsoft et SAP, ainsi que deux pure player qui tirent leur épingle du jeu : Teradata et Snowflake.

Pour les confronter, nous avons choisi 5 indicateurs :

- L’architecture hardware proposée (appliance ou Best of breed)

- Les coûts engendrés

- S’ils sont plutôt spécialisés en datawarehouse ou en datamart analytique

- L’infrastructure « on-premise » ou cloud

- La scalabilité

En conclusion, chaque solution a ses particularités et ses avantages.

- Si vous recherchez une solution Cloud, Snowflake a été conçu pour fonctionner dans le cloud contrairement aux autres solutions qui s’y sont adaptés. Même si Teradata Vantage (« Pervasive Data Intelligence »), nouvelle offre clef de l’éditeur américain est sortie l’année dernière pour contrer l’offre de snowflake, elle semble avoir un léger temps de retard. AWS reste leader des solutions cloud mais leur SGBD n’est pas dans notre benchmark car trop peu diffusé.

- Teradata est une excellente solution on-premise dont les performances sont supérieures au reste du marché, néanmoins le coût est plus important.

Enfin, Oracle est l’éditeur le plus présent sur le marché et donc le plus connu. On trouve ainsi plus facilement des ressources connaissant cette technologie et de la documentation.

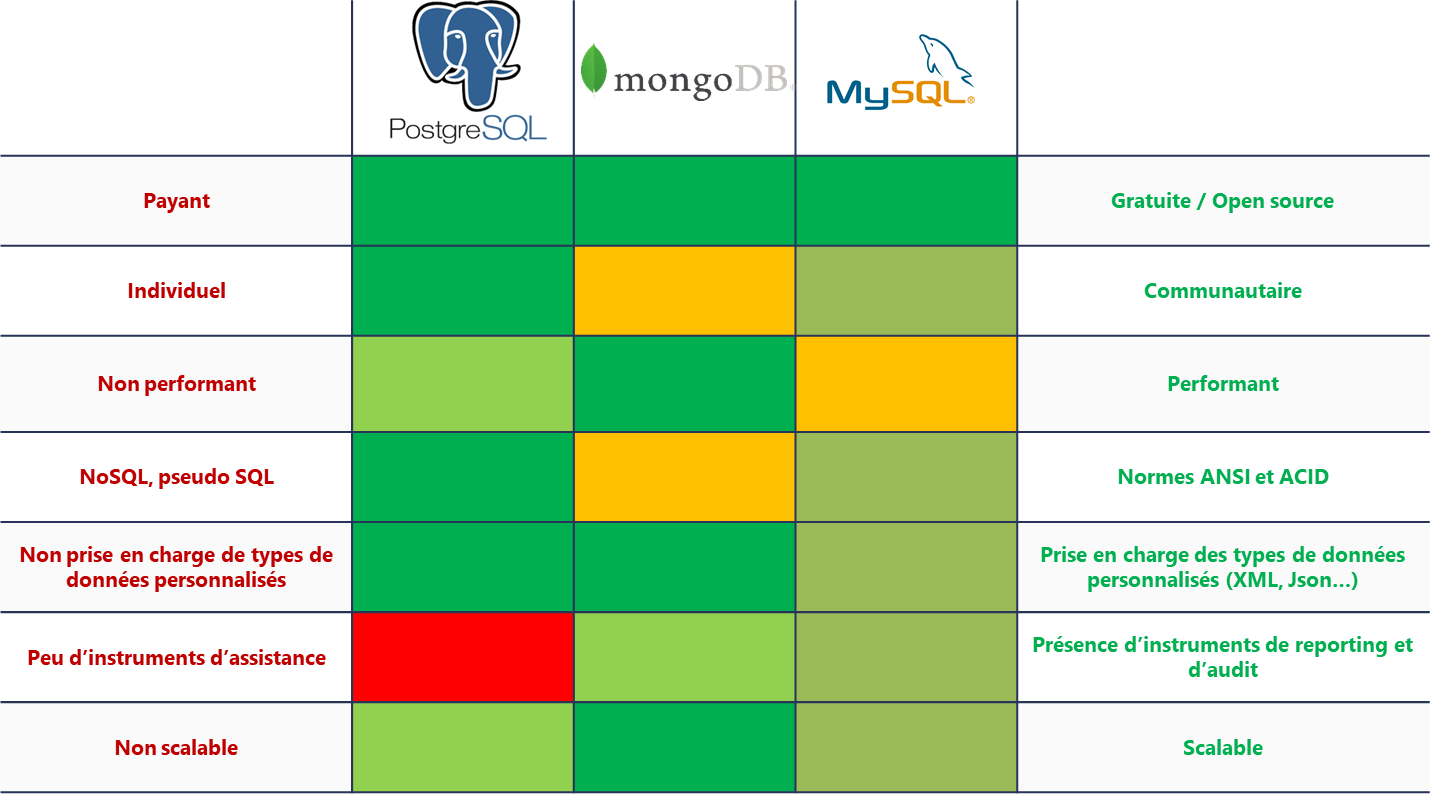

3) Les alternatives open source et gratuites

Dans ce paragraphe, nous avons analysé les solutions gratuites et open source qui peuvent s’avérer des choix intéressants pour limiter les coûts. Nous nous sommes concentrés sur 3 solutions matures qui sont souvent utilisées par nos clients, à savoir : PostgreSQL, MySQL et MongoDB.

Pour les départager, nous avons choisi 7 indicateurs :

- Gratuit / open source (ils le sont tous les 3)

- La taille de la communauté

- Le niveau de performance

- Le respect de la norme ANSI SQL

- La prise en charge des types de données personnalisés (XML, Json…)

- La présence d’outils de reporting et d’audit

- La scalabilité

Ici aussi, chaque solution a ses particularités et ses avantages :

- PostGre SQL est la solution répondant le mieux à la norme ANSI. Cela permet d’avoir des développements SQL facilement portable en cas de migration. C’est également la forme de ce langage-là plus connue. Il est donc plus facile de trouver des ressources maitrisant cette solution.

- Autre avantage de PostGre, la communauté est la plus importante.

MongoDB est la solution la plus performante mais le langage d’interrogations se rapproche du pseudo SQL. C’est aussi la solution ayant une meilleure scalabilité.

III/ Les outils Dataviz

1) Qu’est-ce que les outils Dataviz ?

La data visualisation consiste à représenter visuellement des données, en approche interactive, dans le but de simplifier leur compréhension.

Cette approche marque une volonté d’ouverture car la data n’est plus un domaine réservé aux experts mais s’ouvre à des métiers plus variés.

Les outils de data visualisation permettent de :

- Centraliser l’affichage de la donnée en un seul endroit

- Associer des données provenant de sources diverses

- Donner rapidement le sens à la donnée

- Créer des tableaux de bords personnalisés et les partager

Les outils de data visualisation se positionnent en incontournables dans les enjeux de la BI pour les entreprises. Ils s’inscrivent dans l’idée de démocratisation de la donnée.

Le choix d’un outil de data visualisation doit donc être dicté par un approche reposant sur une solide stratégie data. Des critères pertinents doivent être évalués pour guider la décision.

Cf. L’article « Introduction à l’informatique décisionnelle » pour plus de détail.

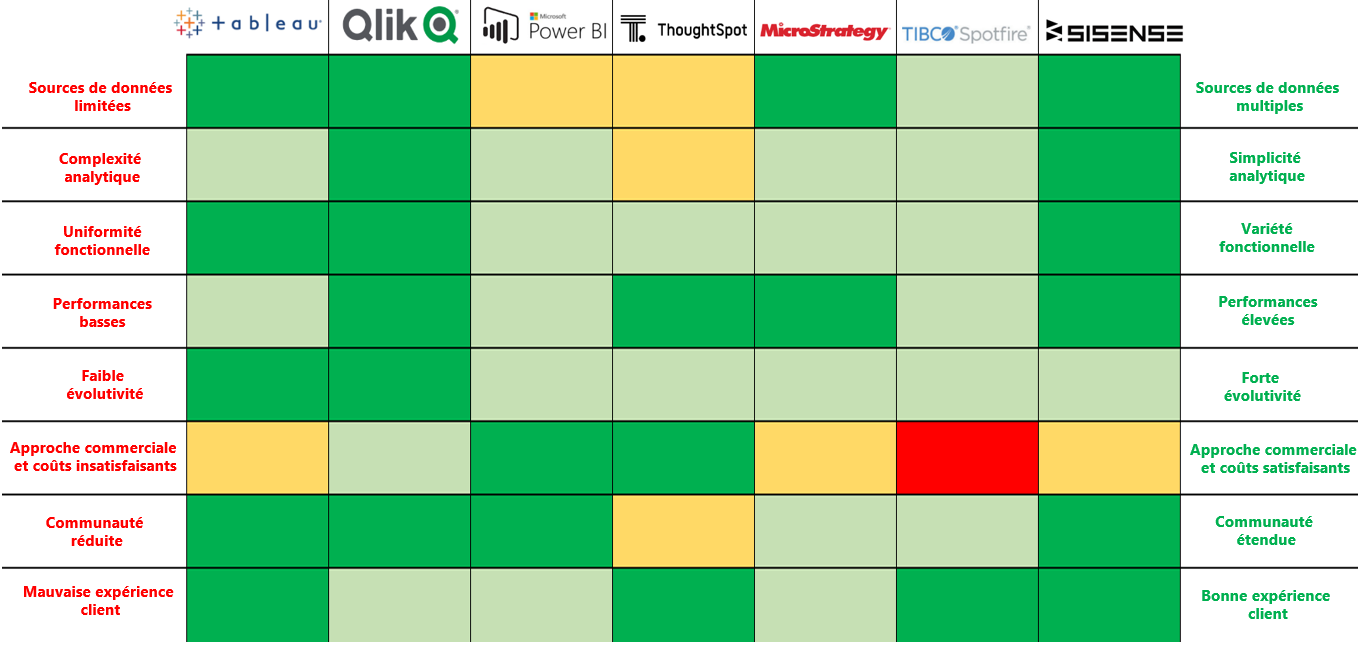

2) Choix de l’outil de data visualisation

Un ensemble de critères doit être étudié par l’entreprise lui permettant de sélectionner l’outil adapté à son besoin.

- Source de données : Les entreprises disposent de nombreuses sources de données. Les outils Dataviz intègrent un module d’extraction des données compatibles avec diverses sources. L’entreprise doit donc identifier ses sources de données pour cibler les outils adaptés.

- Analyse : Les outils Dataviz s’adressent à une population étendue d’utilisateurs. Ils doivent combiner approche simplifiée et analyse approfondie des données. Par exemple, le top mangement qui doit pouvoir accéder rapidement aux indicateurs d’entreprise actualisées.

- Richesse fonctionnelle : Pour étendre les possibilités, un panel de fonctionnalités doit être proposé à l’utilisateur. Il devra pouvoir, via un même outil, réaliser les actions lui permettant de reconstituer l’information. Ne pas démultiplier les outils évite de ‘frustrer’ les utilisateurs et induire des complexités techniques.

- Performances et scalabilité : La capacité des systèmes à traiter efficacement et de manière fluide les données est un argument permettant un confort d’utilisation. Certains éditeurs valorisent cet aspect et misent sur les capacités de leur outil à fournir une performance optimale.

- L’aptitude de l’outil à évoluer avec le temps est aussi importante. L’entreprise doit prendre en compte ce critère, et anticiper son propre plan d’évolution et la mutation de ses systèmes.

- Approche commerciale et coûts : La souplesse des offres doit être étudiée en amont par les clients. La diversité des offres, taillées aux besoins de l’entreprise est un point positif, cela évite le mauvais dimensionnement aboutissant à une utilisation non optimale de l’outil.

- Communauté : Une communauté étendue ajoute de la valeur et assure une maintenance simplifiée. Cela permet aussi de juger du dynamisme de l’outil et présager de son avenir.

3) Outils de Dataviz du marché

a. Focus sur trois éditeurs/outils Dataviz ciblant les grandes entreprises.

- Qlik – Qlik Sense : Qlik Sense propose une souplesse de déploiement ; cloud, on-premise ou mixte. Il dispose d’une bonne évolutivité et d’un moteur ‘associatif’ de recherche de données puissant. Il s’interface avec beaucoup de sources de données. L’outil souffre néanmoins d’un dynamisme considéré comme moindre par rapport à ses concurrents. La migration de produits est estimée complexe.

- Salesforce – Tableau : Tableau est reconnu pour sa simplicité dans l’exploration des données et leur manipulation et la satisfaction des utilisateurs. Il s’inscrit dans une dynamique d’expansion. Côté bémols, la gouvernance et l’administration sont jugées délicates. Des retours négatifs sont aussi à noter pour les parties contractuelles et coûts.

- Microsoft – Power BI : Power BI s’interface bien avec les outils de la suite MS Office et offre un rapport qualité/prix avantageux. Microsoft est dynamique autour de sa solution et n’hésite pas à innover en la dotant de fonctions exclusives. L’outil souffre cependant de carences en termes de connectivité avec des sources de données moins communes. La nécessité d’un environnement MS Azure est un frein à son expansion. Un gap fonctionnel est à signaler entre les versions cloud et on-premise.

Pour entreprises évoluant dans un environnement SI orienté Microsoft nous conseillons d’opter pour la solution Power BI. Pour les entreprises à environnement SI mixte ou un budget plus conséquent nous recommandons Qlik Sense ou bien Tableau.

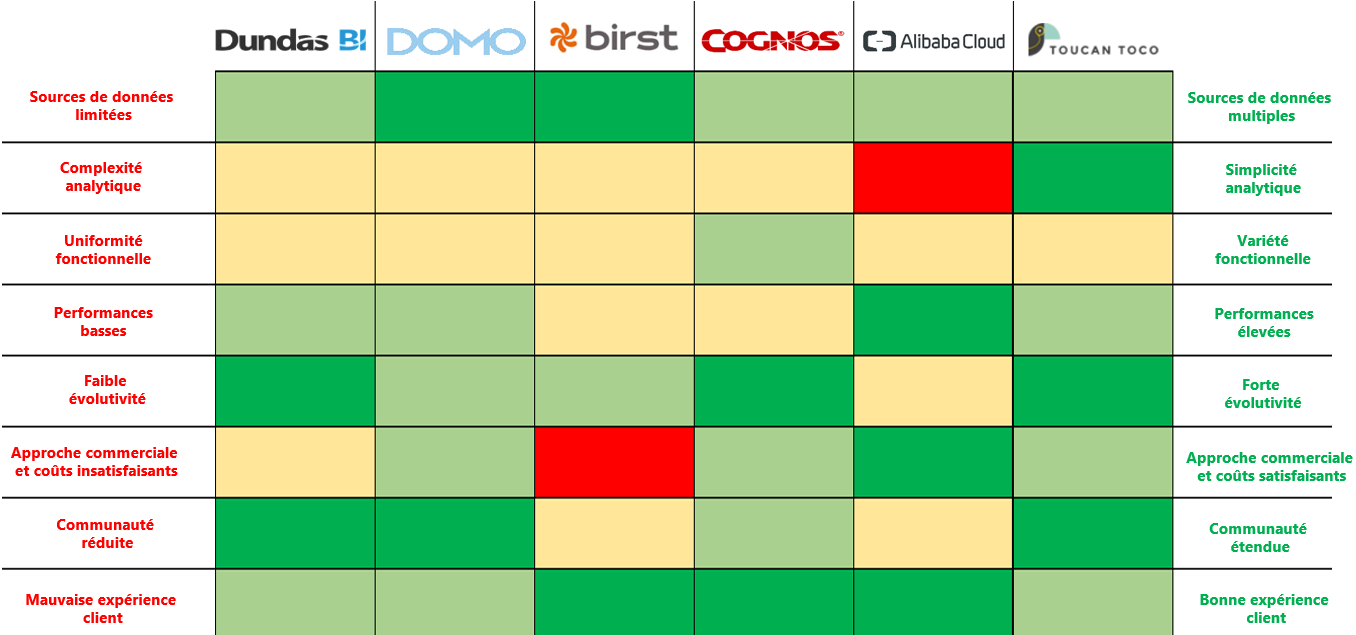

b. Focus sur trois éditeurs/outils Dataviz acteurs de niche ou ciblant les start-up, petites ou moyennes entreprises.

- Dundas BI – Dundas : Dundas propose un module d’analyse BI embarqué et personnalisable. Il allie BI traditionnelle avec des visuels de données statiques et BI moderne avec une approche dynamique. Ainsi, la qualité du support client est appréciée. Côtés faiblesses, sa structure en cube limite sa capacité de traitement de grands volumes de données. La vision produit est aussi un point d’inquiétude car peu d’évolutions sont planifiées. Son coût semble aussi élevé.

- Infor – Domo : Domo propose une approche intuitive et est compatible avec une grande variété de sources. Il dispose ainsi d’une bonne satisfaction des utilisateurs et se démarque par une rapidité de déploiement. Il propose un savant mélange entre BI classique et BI moderne (self BI). Un partenariat avec Snowflake a renforcé sa maitrise du cloud. Il n’est en revanche que peu exploité au maximum de ses capacités. Il souffre d’une présence limitée (USA, Japon, Australie et Royaume-Uni).

- IBM – Cognos : Outil de bout en bout propose une composante Dataviz. Il permet un suivi de l’ensemble du cycle de vie la donnée. Une roadmap d’évolution étoffée atteste d’une solide vision produit. L’expérience utilisateur est un de ses atouts. En contrepartie, Cognos est estimé difficile d’accès pour les ‘power users’ et se positionne paradoxalement rarement comme seule outil BI chez le client. Le coût des licences apparait aussi élevé.

Pour les moyennes entreprises, nous proposons d’opter pour IBM Cognos qui reste une valeur sure car elle propose une solution de suivi de bout en bout de la donnée. Pour les budgets plus limités ou des besoins moins étendus, nous orienterons vers Dundas ou Birst car elles apparaissent comme des valeurs de confiance, ce qui offre des prestations intéressantes.

Si le temps n’est pas une contrainte, nous conseillons cependant de procéder à un benchmark rigoureux et de mettre en concurrence des outils sur la base des critères présentés. Le marché offre une multitude de solutions de Dataviz. Chaque entreprise doit pouvoir identifier un outil répondant à ses exigences.

Conclusion

Les données des entreprises étant souvent hétérogènes et non normalisées, les mettre en commun peut donc s’avérer long et périlleux. C’est à ce moment-là que la Business Intelligence (BI) rentre en jeu ? La BI apporte à l’entreprise les outils pour faciliter et optimiser la prise de décision stratégique et opérationnelle.

Les données traitées sont extraites et chargées via un outil d’ETL. Une fois chargées, ces données sont stockées dans un datawarehouse puis elles sont analysées, traitées et restituées grâce à un outil de data visualisation. Ces trois points essentiels s’appellent la chaîne d’information décisionnelle.

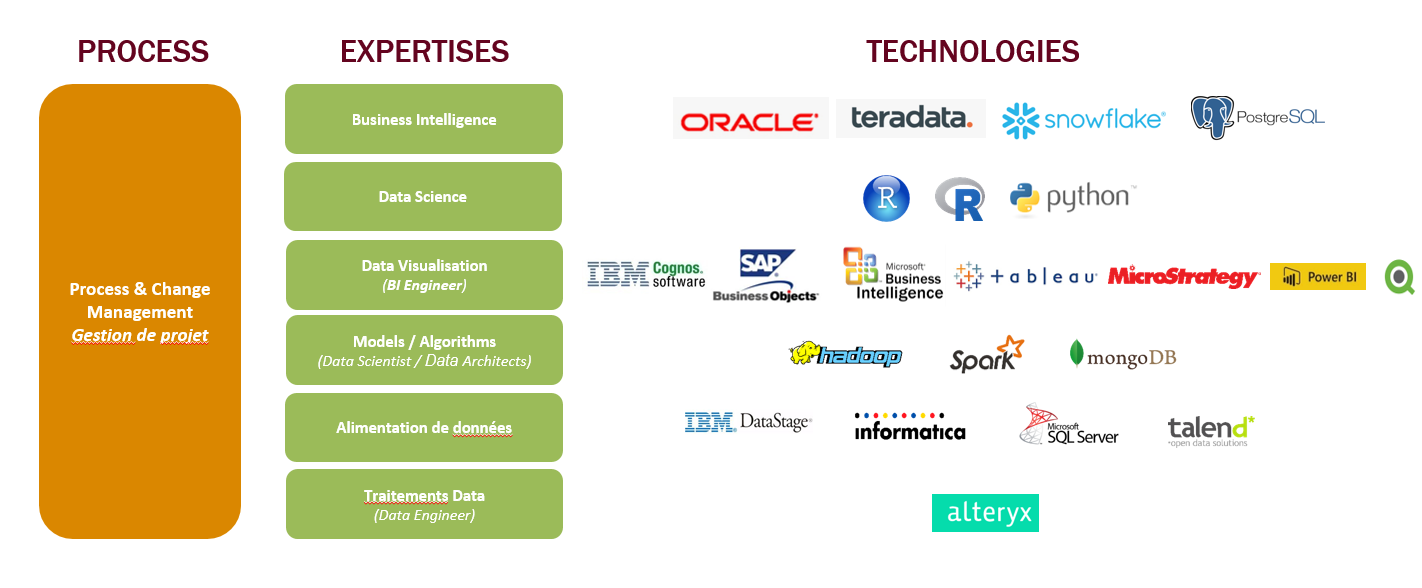

Un grand nombre d’acteurs se partage le marché de la BI : les entreprises et les sociétés de conseils. En effet, cela permet aux entreprises d’accéder à une solution qui correspond à leurs besoins et de s’adapter à leur méthodologie de travail. En ce qui concerne les sociétés de conseil, elles peuvent s’adapter au contexte client, son besoin et sa maturité.

Chez HeadMind Partners, nous nous positionnons principalement sur les expertises suivantes :

Nous proposons une solution agissant sur trois points. Premièrement, elle prendra en compte l’environnement data, l’infrastructure globale et les technologies utilisées. Puis, elle proposera une méthodologie orientée besoins métiers pour avoir une meilleure compréhension des enjeux métiers. Et enfin, elle pourra ainsi suggérer un suivi de projet et d’accompagnement de la phase de la conception à la recette.

Nous disposons également d’un grand nombre de formations pour les solutions BI (ex. SQL, PowerBI, Gestion de projet BI et ses spécificités,…). Ces formations ont pour but, en plus de la montée en compétence, de rester en permanence compétitives.

SOURCES

- Magic Quadrant for Data Integration Tools – Gartner 18 août 2020

- Data integration buyer’s Guide – Solution Review 2020

- Top 12 Free and Open Source ETL Tools for Data Integration – Solution Review 29 mai 2019

- The Forrester Wave™: Data Management For Analytics, Q1 2020 – The 14 Providers That Matter Most And How They Stack Up

- Magic Quadrant for Analytics and Business Intelligence Platforms 2020 – Published 11 February 2020

- 10 outils dataviz pour surveiller et mieux comprendre ses données – Le Monde Informatique

- DataViz – Définition & Top 20 des outils de Data visualisation (cartelis.com)

- Outils – Comment faire son choix parmi tous les logiciels de DataViz du marché (keley-consulting.com)

- Gartner Magic Quadrant for Analysis and Business Intelligence Platforms published 11 February 2020

- The Forrester WaveTM : Enterprise BI Platforms (Client-Managed) Q3 2019